To dobry moment by zająć się tworzeniem prawa, które będzie regulowało użycie sztucznej inteligencji – powiedział Szymon Pękala. Twórca internetowy, prowadzący na YouTubie kanały „Wojna Idei” oraz „Szymon mówi”, w rozmowie z KAI, opowiedział m.in. o szansach i zagrożeniach związanych z rozwojem sztucznej inteligencji, o tym jak księża mogą korzystać z pomocy AI oraz o rozmowie z ChatemGPT, który naśladował Jezusa.

Anna Rasińska (KAI): Ostatnio wiele mówi się o sztucznej inteligencji, dlaczego właśnie teraz zrobiło się tak głośno o AI?

– Szymon Pękala: Wydaje mi się, że jest to przede wszystkim zasługa sukcesu systemów ChatGPT i Midjourney, opartych o działanie sztucznej inteligencji. ChatGPT to chatbot, wykorzystujący zdobytą wiedzę, który odpowiada na nasze pytania. Z kolei Midjourney jest systemem, który na podstawie danych z milionów obrazów, sam generuje obrazy. Oba te wynalazki dają niespotykane wcześniej możliwości, w dodatku dostępne dla każdego, od niedawna są one publicznie otwarte i każdy może z nich skorzystać. Wydaje mi się, że ten boom na AI, wynika właśnie z upowszechnienia tych narzędzi oraz z dostrzeżenia ich ogromnego potencjału.

KAI: Niedawno opublikował Pan film pt. „Jak sztuczna inteligencja zmieni świat?”, w którym przedstawił Pan wiele możliwych scenariuszy związanych z rozwojem AI. Co najbardziej niepokoi Pana w tej kwestii?

– Nie jest tak, że sztuczna inteligencja to tylko zagrożenie. Przede wszystkim warto zaznaczyć, że jest to narzędzie, które może w widoczny sposób ułatwić wiele dziedzin życia, branż, usług, które dzięki temu staną się wielokrotnie tańsze i bardziej dokładne. Jedną z nich, może być chociażby sztuka tworzona przez sztuczną inteligencję. Oczywiście martwi to artystów, którzy obawiają się, że wkrótce zostaną wygryzieni.

Mam wrażenie, że w ogólnym zachwycie nad możliwościami sztucznej inteligencji, brakuje niestety refleksji nad tym, że każde wynalezione narzędzie niesie za sobą nowe potencjalne zagrożenie, a to może być najpotężniejsze narzędzie jakie stworzyliśmy. Nie mówię konkretnie o Chacie GPT czy Midjourney, ale o tej technologii.

Jednym z najbardziej realnych zagrożeń jest likwidowanie pewnych zawodów. To oczywiście nie jest nic nowego w perspektywie historii, ale wcześniej zmiany zachodziły dużo wolniej. Poza tym powstawały nowe branże, które potrzebowały pracowników o podobnych kompetencjach i wynagrodzeniu. W tym momencie zmiana jest znacznie szybsza, a zawody nie tak łatwe do zastąpienie nowymi.

Przykładowo, samochody autonomiczne mogą pozbawić zatrudniania kierowców ciężarówek, a w samych Stanach Zjednoczonych kierowców ciężarówek jest ok. 3 mln. Może się okazać, że nagle, w przeciągu kilku lat, wiele osób zostanie bez pracy. Rewolucja AI nie otwiera łatwo dostępnych zawodów tzn. będziemy potrzebowali ludzi, pracujących nad rozwojem sztucznej inteligencji. Powstanie na pewno dużo miejsc pracy w branżach około technologicznych, ale kierowca ciężarówki, bez wykształcenia technicznego, nie znajdzie tam zatrudnienia. Nie ma łatwej ścieżki przekwalifikowania się z zawodu kierowcy, do profesji osoby, pracującej ze sztuczną inteligencją.

Może to stworzyć grupy osób, z którymi nie będzie wiadomo co zrobić na rynku pracy. To jeden z wielu scenariuszy, bardzo przyziemny…

KAI: A co ze scenariuszami jak z filmów science fiction, w których sztuczna inteligencja przejmuje kontrolę nad naszym światem i postanawia zniszczyć ludzkość?

– Dla mnie jest to zbyt nierealny scenariusz żeby się go bać. Prawdziwe zagrożenia i problemy są na tyle ciche i prozaiczne, że znacznie łatwiej je przeoczyć. Każde nowe narzędzie, nie tylko zwiększa kontrolę człowieka nad przyrodą, czy procesami wokół niego, ale i nieuchronnie zwiększa kontrolę i władzę jednych ludzi nad drugimi. Myślę, że coraz częściej będziemy mieć do czynienia z algorytmami, których zadaniem będzie np. wyłapywanie potencjalnie niebezpiecznych zachowań. Być może zwiększą one nasze bezpieczeństwo, ale i mogą ograniczać wolność osobistą. Wiele zależy od tego kto będzie dysponował sztuczną inteligencją. Nawet młotek w rękach nieodpowiedzialnej osoby może być niebezpieczny, a tak dużego młotka jeszcze nie mieliśmy

KAI: Pojawiają się głosy naukowców, którzy stawiają tezę, że rewolucja AI nie może się skończyć dobrze dla ludzkości. Czy Pan potrafi sobie wyobrazić pozytywny scenariusz?

– Jest bardzo dużo dziedzin, które bez wątpienia zostaną ułatwione i udoskonalone, część ludzkiej pracy będzie wykonywała sztuczna inteligencja. Każda rewolucja technologiczna wielokrotnie zwiększała naszą produktywność i ostatecznie kończyła się pomnażaniem naszych możliwości. Na przykład ta radykalna zmiana, która dokonała się przez rewolucję przemysłową podniosła nas z poziomu życia ludzi, którzy ledwie mogą zaspokoić swoje podstawowe potrzeby, bo większość społeczeństwa zmagała się wtedy z horrendalną biedą. W tym momencie nasz poziom życia diametralnie się poprawił, a ogromna większość ludzkich potrzeb jest zaspokojona. Ludzie raczej skupiają się na kwestiach wygody, nikomu nie grozi zamarznięcie w zimie.

Pozostaje pytanie na co w takich warunkach zostanie spożytkowana ta wysoka produktywność. Myślę, że obawy są uzasadnione. Może się zdarzyć, że zmiany te ułatwią wyzyskanie naszych negatywnych impulsów przez ludzi, którzy na tym zarabiają. Obawy naukowców , że prędzej dojdzie do katastrofy na niewyobrażalną skalę niż nauczymy się kontrolować te narzędzia, oczywiście mogą okazać się prawdziwe.

Zwróćmy jednak uwagę, że taka sama obawa towarzyszyła światu w momencie poznania możliwości energii atomowej, a jednak nie doszło do wielkiej tragedii. Groźba zniszczenia całego cywilizowanego świata, która była bardzo realna w czasie zimnej wojny, mimo wszystko obecnie jest mniejsza. Bezpośrednie korzyści z energii atomowej są powszechnie dostępne, wkrótce może i u nas. Zatem wydaje mi się, że w kwestii AI można zakładać podobną argumentację.

Jest to jedno z poważniejszych zagrożeń, ale również źródło niesamowitych możliwości. Bez wątpienia jest to ekscytujące – żyć w takich czasach!

KAI: Jak Pan sądzi, czy w przyszłość AI może wpłynąć na nasze życie religijne? Czy również na tej płaszczyźnie dostrzega Pan jakieś zagrożenia?

– Myślę, że dla życia religijnego w dzisiejszym świecie już jest bardzo dużo zagrożeń, akurat w tym miejscu bym ich nie szukał. Choć faktycznie może nastąpić większa hedonizacja życia, czy uzależnienie od technologii. To może mieć wpływ na życie religijne.

Również w tym aspekcie, dostrzegam jednak wiele możliwości. Już widziałem generowane przez AI rozważania na Drogę Krzyżową, księża będą mogli wspomagać się sztuczną inteligencją podczas pisania kazań. Umówmy się, wielu księży przerasta to zadanie. Bez wątpienia jest to narzędzie, które może im pomóc. Jeżeli pomoc w postaci sztucznej inteligencji pozwoli im być lepszymi w tym co robią, to czemu nie. Można też poprosić ChatGPT o opracowanie pewnych tekstów. Np. by w prosty sposób opisał przemyślenia świętych lub skomplikowane koncepcje filozoficzne. Kościół często ma problem z wykładaniem na prosty język treści, które nie są do końca zrozumiałe.

Poza tym Chat GPT można „nakarmić” danymi na temat znanych osób, czy postaci historycznych, a on świetnie je imituje. Można go poprosić: „porozmawiaj ze mną jak … i podajemy postać historyczną”. Ja w ten sposób rozmawiałem z Chatem, który udawał Jezusa.

KAI: To faktycznie świetny pomysł. I jak wrażenia?

– Robił to naprawdę zaskakująco dobrze, choć Chat GPT jest w swoich założeniach poprawny politycznie więc, na pytanie który Kościół ma rację, zaczął kręcić, a przecież jako Jezus powinien wiedzieć [uśmiech].

KAI: Wiele osób boi się momentu, w którym sztuczna inteligencja będzie mogła podejmować autonomiczne decyzje. Bywa, że sami nie wiemy co jest dobre a co złe, a co dopiero AI… Myśli Pan, że możliwe jest by nauczyć sztuczną inteligencję moralności?

– To pytanie wynika z powszechnego braku rozumienia tego, czym właściwie jest sztuczna inteligencja. Oczywiście, że nie można nauczyć jej moralności, bo sztuczna inteligencja nie dokonuje żadnych świadomych wyborów. Naprawdę uważam, że nie ma najmniejszych powodów by uważać, że którekolwiek z naszych dzieł uzyska samoświadomość w dającej się przewidzieć przyszłości.

AI można nauczyć moralności na tej zasadzie, że można spisać pewne zasady i „nakarmić” tym sztuczną inteligencję. Później sprawdzić jak na tej podstawie będzie ona rozumować. Natomiast w momencie kiedy sztuczna inteligencja, na podstawie spisanych zasad, wyda jakiś osąd moralny, pojawiają się pytania – czy można mu wierzyć oraz kto będzie odpowiedzialny za skutki tych decyzji. W pewnym momencie sztuczna inteligencja będzie musiała dokonywać wyborów, które będą miały poważny wpływ na ludzkie życie. Ponieważ jest to narzędzie tak daleko odsunięte od twórcy, ciężko będzie określić kto jest odpowiedzialny za jej błędne decyzje.

Co za problem wyobrazić sobie sztuczną inteligencję stworzoną przez jakiś obcy rząd, która ma na celu „chronić” interes partyjny, nawet kosztem zdrowia i życia ludzi. Myślę, że nie ma co się bać w skali ogólnoludzkiej, ogólnonarodowej, ale lokalnie, jak najbardziej. W Stanach Zjednoczonych są już w użytku roboty policyjne, których w niektórych wypadkach można użyć do „zneutralizowania celu” czyli zabicia niebezpiecznego człowieka. Oczywiście wciąż odbywa się to za pośrednictwem ludzi, kierujących maszynami. Kolejnym krokiem może być taka maszyna wyposażona właśnie w sztuczną inteligencję, która, sama określi czy konkretny człowiek jest dostatecznie niebezpieczny, żeby zastosować wobec niego śmiercionośną przemoc, czy nie.

KAI: Przykładem może być tu kwestia samochodów autonomicznych, które w razie wypadku, niejednokrotnie będą musiały wybrać czyje życie chronić – pasażera czy uczestników ruchu.

– No właśnie, bo sztuczna inteligencja zrobi to, czego ją nauczyliśmy. Programista obsługujący ją, będzie musiał podjąć pewne decyzje, dotyczące wagi życia kierowcy i pasażera. A co jeśli w takim samochodzie jedzie dziecko? Co jeśli na przejściu jest staruszka? Te zasady będą musiały powstać w oderwaniu od faktycznej sytuacji, programiści będą mogli jedynie spekulować jakie sytuacje napotka bot w tym samochodzie. A co jeśli Musiałyby również zostać określone pewne sytuacje, w których samochód powinien się zachować ze szkodą dla kierowcy?

KAI: Tylko kto wsiądzie do samochodu, który w razie wypadku może poświęcić życie pasażerów?

– Otóż to, kto kupi samochód, który w pewnych warunkach mógłby narazić pasażerów na szwank, kosztem innych uczestników ruchu drogowego. To są wszystko bardzo ważne pytania otwarte. Myślę, że już należy o tym myśleć. A także o tym kto ponosi odpowiedzialność za błędy AI, bo niewątpliwie ktoś powinien.

KAI: Co Pan myśli o apelu o zatrzymanie prac nad rozwojem AI, czy jest to w ogóle możliwe na tym etapie?

– Myślę, że jest to absolutnie niemożliwe. Sam Elon Musk, który go podpisał, dosłownie kilka tygodni później zaczął rozwijać swoją własną sztuczną inteligencję. Jednak nawet jeśli jest to apel niemożliwy do wykonania, to dobra forma zwrócenia uwagi na to, że powinniśmy z naszego nowego narzędzia korzystać ostrożnie. To dobry moment by zająć się tworzeniem prawa, które będzie regulowało użycie sztucznej inteligencji.

Rozwój sztucznej inteligencji jest oczywiście przestrzenią potencjalnych zagrożeń, ponieważ jest to być może jedno z najbardziej potężnych narzędzi jakie udało nam się stworzyć w historii. Idą za tym również ogromne możliwości ułatwienia naszego życia. Ważne żeby nie tracić z oczu żadnej z tych perspektyw. By nie być zbyt optymistycznym, mieć świadomość zagrożeń, ale i nie fatalizować, bo możemy przegapić bardzo pozytywną zmianę.

Dziękuję za rozmowę.

***

Wspomniany w wywiadzie film „Jak sztuczna inteligencja zmieni świat”:

Szymon Pękala (ur. 1990 w Rzeszowie) – polski twórca internetowy, autor artykułów oraz książki „Wojna Idei. Myśl po swojemu”, prowadzący kanałów na YouTubie Wojna Idei, Szymon mówi oraz War of Ideas.

Źródło: https://www.ekai.pl/szymon-pekala-czas-zajac-sie-tworzeniem-prawa-ktore-bedzie-regulowalo-uzycie-ai/

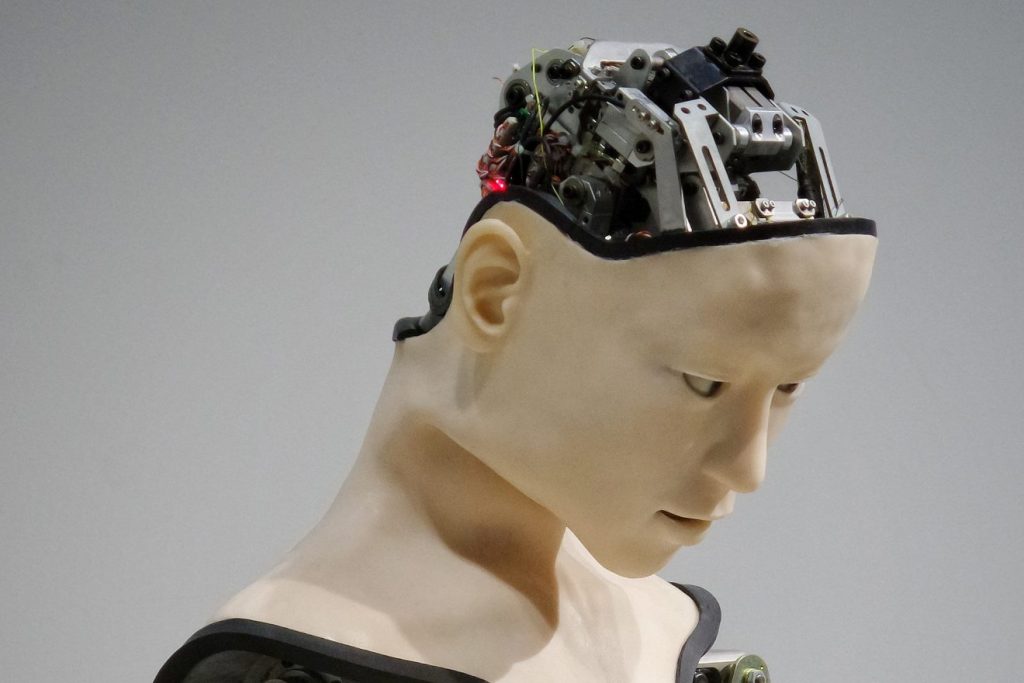

Fot. Franck V. / Unsplash